|

Atomzeitalter

Als Atomzeitalter oder Nuklearzeitalter wird die gegenwärtige Epoche der Menschheit bezeichnet, wo Energie aus dem radioaktiven Zerfall schwerer Kerne, der Verschmelzung leichter Kerne oder der Reaktion von Materie mit Antimaterie genutzt wird. Dies kann zu verschiedenen Zwecken erfolgen. Die aus der Erforschung dieser Prozesse gewonnenen Erkenntnisse führen zu weiteren technologischen Entwicklungen, was in der Regel mit dem Begriff Quantenzeitalter beschrieben wird. Die so entstehende fortschrittliche Industriegesellschaft des Nuklearzeitalters wird auch als Hyperenergiegesellschaft bezeichnet. Inzwischen beruhen etwa 25 Prozent des Bruttosozialprodukts von Industriestaaten auf der Quantenphysik.[1]

- „Da liest man nun seit Jahren von der Atomenergie. Man hört, wie vernichtend sie in einer Bombe wirken kann, aber auch wie viel Segen sie der Menschheit bringt, wenn sie sinnvoll eingesetzt wird. Man weiß, dass man mit Hilfe der kleinen unscheinbaren Atome die Welt aus den Angeln heben kann; man weiß aber auch, dass sie einen für unsere Begriffe unendlich großen Vorrat an Wärme und damit Elektrizität enthalten. Man weiß, dass jedes Ding, das man in die Hand nimmt, ja, dass man selbst aus Atomen besteht, und doch bleiben die Atome eine recht unwirkliche Sache, unwirklich etwa, wie uns das Leben Julius Cäsars erscheint oder die Existenz der Antarktis.

- Doch dann betritt man eines Tages ein etwas größeres Holzhaus. Sein einziger Raum ist nicht viel größer als ein Klassenzimmer. Ein mystisches Dunkel herrscht, nur an den Wänden sind einige Schaukästen erleuchtet. Man tritt in die Mitte des Raumes und blickt in einen Brunnenschacht. Zwei Meter Durchmesser und sieben Meter Tiefe mag er haben und ist fast bis zum Rand mit Wasser gefüllt. Das aber, was man auf dem Grund des Schachtes sieht, das ist ohne Beispiel. Einige hohe schlanke Kästen stehen da eng beieinander. Sie selbst haben nichts weiter an sich. Aber diese "Blechdosen" sind von einem eigenartigen bläulichen Lichtschein umgeben. Das Wasser um sie herum leuchtet kräftig – und doch erkennt man die einzelnen Kästen gut. Wenn die Physiker für diese Cerencov-Strahlung keine sinnvolle Erklärung gefunden hätten, dann könnte man fast an ein überirdisches Phänomen glauben, so gespenstisch ist das Bild. […]

- Dieses Erlebnis hatte ich im August 1955 in Genf bei der berühmten Atomkonferenz. Ich sah den ersten Atomreaktor in Betrieb, der zur öffentlichen Besichtigung freigegeben worden war. Bis dahin hatte ich mir eingebildet, dass mich auf atomtechnischem Gebiet so leicht nichts erschüttern könne. Aber es war doch ein ganz eigenartiges Gefühl, nun plötzlich einem leibhaftigen Atomreaktor gegenüberzustehen. Da vollzog sich etwas vor meinen Augen, was bisher nur ganz wenige Menschen an den geheimsten Orten der Erde gesehen hatten. Da spielte sich zu meinen Füssen das sagenumwobene Phänomen der Kettenreaktion ab, ein Phänomen, um dessen technische Nutzung sich die Wissenschaftler und Techniker in der ganzen Welt bemühen. Mit einem Male wurde mir bewusst, dass dieses Atomzeitalter, von dem so viel gesprochen wird, mehr als nur ein leeres Schlagwort ist. Diesen Schritt vorwärts in der technischen Entwicklung kann man höchstens noch mit der Erfindung der Dampfmaschine oder der Entdeckung der Elektrizität vergleichen.

- Was mich aber am meisten beeindruckte, das war die Sicherheit und Zuverlässigkeit, mit der man diesen Reaktor steuern konnte. Vor wenigen Jahren noch galt ein Atommeiler als ungeheuer gefährlich und sehr schwierig zu handhaben. In den kühnsten Träumen wagte man sich damals nicht vorzustellen, dass man einmal die aktive Zelle eines Reaktors würde sehen können, so wie ich jetzt die Brennstoffelemente im bläulichen Licht der Cerencov-Strahlung vor mir sah. […]

- All das ist keine technische Spielerei oder eine übertriebene Fortschrittsbegeisterung. Der Bau von Atomkraftwerken ist für die Menschheit notwendig, denn der Vorrat an herkömmlichen Energielieferanten – Kohle, Erdgas, Erdöl und Torf – geht bereits bedrohlich zur Neige. Wir verbrauchen gegenwärtig an einem einzigen Tag von diesen Energievorräten mehr, als die Natur in 10 000 Jahren eingelagert hat. Die Vorräte an Kohle und Erdöl in der Kruste unserer Erde sind aber begrenzt, und einerlei, ob wir nun das elektrische Licht anschalten, im Ofen stochern oder auf den Gashebel unseres Autos treten, immer verzehren wir ein klein wenig von dieser begrenzten Energiemenge. Der Energiebedarf der Welt wächst aber noch ständig, er wird bis zum Jahre 2000 auf mehr als das Achtfache des heutigen Verbrauches angestiegen sein. Wenn die Entwicklung so weitergeht und keine neuen Energiequellen erschlossen werden, dann wird spätestens in 150 Jahren das letzte Flugzeug mit dem letzten Liter Treibstoff irgendwo notlanden, wird irgendwo eine Hausfrau die letzte Schaufel Kohlen in den letzten Küchenherd werfen. Auf der berühmten Atomkonferenz im August 1955 in Genf gipfelten die Diskussionen über den zukünftigen Weltenergiebedarf in der Feststellung: "Wenn die Atomenergie nicht bereits entdeckt wäre, würde es höchste Zeit dafür." […]

- Genauso, wie wir uns heute kaum vorstellen können, dass unsere Groß- und Urgroßväter in ihrer Jugend keine Eisenbahn und erst recht kein Auto und kein Flugzeug kannten, genauso werden es unsere Enkel kaum verstehen können, wie wir einmal ohne Atomenergie auskommen konnten.[2]

Betrachtungen

Das Nuklearzeitalter

- „Die Menschheit steht an der Schwelle zur zweiten industriellen Revolution. Drei Elemente kennzeichnen sie: Die Atomenergie, die Automation und elektronische Maschinen. Die Entfesselung der neuen Kräfte kann zur Vernichtung allen Lebens auf dieser Erde, ihre Bändigung zu nie geahntem Wohlstand für alle Menschen führen. Zum ersten Male können Armut und Hunger auf der ganzen Erde gebannt werden.

- […]

- Der Parteitag verabschiedet einen Atomplan: Die kontrollierte Kernspaltung und die auf diesem Wege zu gewinnende Kernenergie leiten den Beginn eines neuen Zeitalters für die Menschheit ein.

- Die Erzeugung von Elektrizität aus Kernenergie hat in solchem Umfang zu erfolgen, daß die deutsche Wirtschaft nicht mehr auf die Einfuhr überteuerter Kohle angewiesen ist, der Raubbau in Kohlengruben vermieden und die schädigende Veränderung von Landschaft und Wasserversorgung beim Abbau von Braunkohle eingeschränkt wird; der Aufbau und der Betrieb von Atomkraftwerken wird durch die öffentliche Hand durchgeführt, ihr Zusammenwirken mit den übrigen Elektrizitätserzeugungsunternehmen erfolgt nach langfristig festzusetzenden Plänen;

- die Entwicklung von Kernkraftmaschinen an Stelle der Dieselmotoren und anderer Verbrennungskraftmaschinen für feste und fahrbare Kraftstationen, für Schiffe, Flugzeuge und andere Verkehrsmittel muß den Platz Deutschlands in der Reihe der Industrievölker sichern;

- die Verwendung der radioaktiven Isotope in Medizin, Biologie, Landwirtschaft und Industrie muß so gefördert werden, daß die großen Möglichkeiten für die Gesundheitspflege, die Züchtung neuer Pflanzenarten und die Anwendung für die technischen Produktionsprozesse auch für Deutschland voll erschlossen werden;

- die Forschung im Bereich der Atomwissenschaft und die Ausbildung von Arbeitskräften aller Art, müssen mit allen Kräften gefördert werden, sowohl die mit Kernstoffen Arbeitenden als auch die gesamte Bevölkerung müssen mit allen Mitteln und mit aller Sorgfalt gegen die Strahlenwirkungen geschützt werden.

- Die deutsche Öffentlichkeit, das Parlament und die Regierung benötigen zur Beurteilung der Gesamtsituation und aller Veränderungen eine kontinuierlich arbeitende, unabhängig gutachterliche Beratung.

- Die SPD fordert deshalb die Errichtung einer deutschen Atomkommission. Kernbrennstoffe können insbesondere durch Unglücksfälle oder Mißbrauch große und fortwirkende Schäden an Leib, Leben und Gütern hervorbringen. Deshalb muß die Allgemeinheit über den Staat und seine Organe schärfste Kontrolle und sorgfältigste Aufsicht auf allen Gebieten der Erzeugung und Verwendung von Kernbrennstoffen ausüben.

- Um dieses zu sichern, ist ein »Deutsches Organ für Kernbrennstoffe und die Überwachung ihrer Verwendung« durch Gesetz als Bundeseinrichtung zu schaffen. Die Atomenergie kann zu einem Segen für Hunderte von Millionen Menschen werden, die noch im Schatten leben. Deutschland muß in der Hilfe für diese Völker mitwirken, aber auch die Lebensmöglichkeiten des eigenen Volkes verbessern.“

- – 10./14. Juli 1956 Parteitag der SPD in München[3]

Der Begriff atomic age wurde bereits verwendet, noch bevor die erste kontrollierte Kernspaltung ablief. So verwendete zum Beispiel Abraham Gould Jenning den Begriff in seinem Werk The Earth and the World. How Formed?: A Layman's Contribution to the Religious Though of the Times bereits 1900. Unter der Kapitelüberschrift The Atomic Age of Creation spekuliert er über die Entstehung der ersten Elemente im Universum, und des Sonnensystems.[4] Irgendwann zu dieser Zeit wurde der Begriff des Atomzeitalters Teil des gesellschaftlichen Bewusstseins.

Der Journalist Ron Rosenbaum prägte 2008 den Begriff first atomic age für die Geschichte nach den Kernwaffeneinsätzen über Hiroshima und Nagasaki, sowie den Begriff des second atomic age für die Zeit nach dem Ende des Kalten Krieges. In seinem Essay äußerte er sich kritisch über das heutige, lebensfrohe Hiroshima, das die Spuren des Krieges so erfolgreich hinter sich gelassen hat.[5] Die kognitive Dissonanz zwischen der Tatsache, dass man Kontamination einfach entfernen kann, und der Propaganda der Angstindustrie mit ihrem Märchen „Millionen-Tote, für-zehntausende-Jahre-unbewohnbar“, wird beim Lesen des Essays deutlich.[A][6]

Der Geschichtsprofessor Matthew Lavine von der Mississippi State University hält diese Einteilung selbst für kulturelle Amnesie. Matthew Lavine's Essay The First Atomic Age Scientists, Radiations, and the American Public, 1895–1945 ist der einzige, der sich mit dem Zeitgeist vor den Atombombenabwürfen beschäftigt. Ein Essay, der sich im selben Zeitraum mit der Kulturgeschichte auseinandersetzt, ist Spencer Weart’s Nuclear Fear: A History of Images, welcher die Symbolik der Nuklearenergie und ihre psychologischen Grundlagen thematisiert. Die Fachliteratur über die Kulturgeschichte der Kernenergie ist sehr umfangreich und tiefgehend, sodass sie nicht adäquat zusammengefasst werden kann. Die Ikonographie wie zB der Atompilz, die Geschlechterpolitik der Kernenergetik der 1980er Jahre, die Auswirkungen der Nukleartechnik auf die nationale Identität usw. Alle diese Studien bezogen sich auf die Post-Hiroshima-Welt, und blendeten alles aus was vor dem Trinity-Test geschah.[5]

Rosenbaum begann seine Einteilung der Atomzeitalter ab 1945 aus offensichtlichen Gründen. Wenn man aber das Bewusstsein über die zerstörerischen Möglichkeiten des Urans, und die Strahlenangst als Grundlage nimmt, zeugt diese Einteilung von kultureller Amnesie. Mit der Entdeckung der Röntgenstrahlen 1895 und der Radioaktivität 1896 nahmen alle Amerikaner – und, so ist zu vermuten, auch Bürger anderer „westlicher“ Länder – an der Debatte und Darbietungen teil, die aus der wissenschaftlichen Erforschung des Atoms resultierten. Das Nuklearzeitalter vor 1945 auszublenden ist auch deshalb problematisch, weil damals bereits ein großes Netzwerk von Akteuren den Diskurs gestaltete. Röntgenstrahlen und Radium waren vollständig kommerzialisiert, nicht nur in Form von strahlenden Produkten, sondern auch durch Bücher, Vorlesungen und Presseberichte. Die Anbieter von Radiumsalben und Röntgenportraitstudios beeinflussten maßgeblich die Wahrnehmung dieser Energien. Dazu kamen zahllose Akteure, Erzeuger und Käufer gleichermaßen, die das Narrativ begleiteten wie, wann und unter welchen Bedingungen diese Kräfte auf den Markt gebracht werden könnten. 1913 brachte die New York Times eine Titelgeschichte über einen krebskranken US-Senator, der durch eine Strahlentherapie geheilt werden sollte. In blumenreichen Worten wurde die Behandlung und der Tod des Patienten einige Monate später geschildert. Eine Patientin, die im Jahre 1905 ihre Röntgenuntersuchung bekam, hatte mit ziemlicher Sicherheit eine relativ gute Vorstellung davon was die Maschine tat, welche Beschwerden mit ihr diagnostiziert werden konnten, und wie ihre Bilder aussehen würden. Die Patientin hätte ebenso eine Jahrzehnt lange Erfahrung mit „Röntgenstrahlung“ als rhetorische und metaphorische Entität: In dieser Zeit wurde das Wort mit den Adjektiven allwissend, durchdringend, aussetzen, modern, mystisch, wichtig, unergründlich und wissenschaftlich konnotiert. Für diese Person wäre Radium je nach Kontext ein Ding der Wissbegierde, ein Symbol der Zeit, ein Symbol des Wohlstandes, eine Verbraucherneuheit und ein medizinisches Mittel für schwere Fälle.[5]

US-Amerikaner betraten das Atomzeitalter deshalb nicht unvorbereitet: Der unvergleichlich dramatische Auftritt, mit dem Atomwaffen ihr Debüt gaben, überraschte die Öffentlichkeit, aber nicht die Waffen selbst. Weil es seit 40 Jahren ein Grundthema der spekulativen Literatur war, war die Atombombe ein gut verstandenes Konzept, wie Luke Skywalker's Lichtschwert, wenn es plötzlich im Handel erhältlich wäre. Radioaktiver Fallout – wenig erforscht in Science-Fiction und tatsächlich von Manhatten-Project-Wissenschaftlern selbst stark unterschätzt – erschreckte nicht nur in den Nachrichten aus dem besetzten Japan, sondern auch weil das Konzept der heimtückischen Vergiftung durch nicht nachweisbare Radioisotope der Öffentlichkeit seit Jahrzehnten eingehämmert wurde. Nukleartouristen, die zum Picknicken aufbrachen um Pilzwolken aus Bombenversuchstests zu sehen, fuhren auf denselben Straßen, die Gesundheitstouristen zu den Radiumquellen geführt hatten: Die Berge und Wüsten des Westens hatten in der mentalen Karte der Amerikaner schon seit Jahrzehnten ein schwaches radioaktives Grün.[5]

Der Geschichtsprofessor Kirk Willis von der University of Georgia prägte den Begriff der Nuklearkultur (engl. nuclear culture) und zeigte in einem Essay, dass diese in Großbritannien weit vor Hiroshima und Nagasaki lebendig war. Das Wissen, die Bilder, die Artefakte angewandter Kernphysik waren durch populäre Bücher, Filme, Science-Fiction-Magazine, Nachrichtenmagazine, Demonstrationen usw bereits in den öffentlichen Diskurs gespeist, und dadurch Teil der kognitiven Karte vieler Briten. Die von John Bradley von der University of Arizona herausgegebene Textsammlung Learning to Glow: A Nuclear Reader nennt die Ikonographie des Atomzeitalters: Der Schutthaufen von Hiroshima, die Doomsday Clock, Bert the Turtle, und Slim Pickens der eine Atombombe reitet. Bilder, mit denen der Durchschnittsbürger Umgang pflegte.[5]

Unter diesem Aspekt ist auch der Begriff des Nuklearzeitalters zu verstehen: Als griffiges Schlagwort für Kulturgeschichtler, ähnlich dem Weltraumzeitalter (engl. space age). Die informellen Unterteilungen in verschiedene Atomzeitalter sollen die Wirkmächtigkeit einer Idee in der Breite einer Kultur verdeutlichen. Das Verständnis der US-Amerikaner von Radioaktivität war komplex genug, um jede momentane Erfahrung oder persönliche oder mediale Ansprache zu überdauern. Diese Ideen waren sozusagen die Linse, durch die US-Amerikaner – und Bürger anderer „westlicher“ Länder – die Kultur in der sie interagierten interpretierten. Die Reaktion der Masse auf diese Stimuli ist deshalb sehr vorhersagbar. Der Reaktorunfall in Fukushima-Daichi als Folge des Tsunamis war beispielsweise unerwartet, aber nicht der Diskurs der sich daraus ergab, da er durch Tschernobyl, Three Mile Island und weitere Unfälle bereits einstudiert gewesen ist. Rosenbaums Überlegungen selbst tauchen auch jedes Jahr zu den Hiroshima-Gedenktagen im öffentlichen Diskurs auf.[5] Die Flucht in ein routiniertes Erinnern geht schnell, in moralisierenden Autismus und ein fühlloses Fühlen, in dem jedes unerwartete Negativereignis zum passablen Baustein des eigenen Entwicklungsromans wird, der freilich auch eine ganz banale Seifenoper sein könnte. In dem die Ökologisten ihre Hysterie ausleben, mit ihren Ikonographien, Stichworten und Assoziationen, reproduzieren sie die Nuklearkultur, und tragen so zum Atomzeitalter bei.

Am soziotechnischen Themenkomplex ändert dies nichts. Das was zur Zeit des SPD-Parteitages Atomenergie, Automation und elektronische (Rechen-)Maschinen waren, ist im heutigen Diskurs eben Kernenergie, Automatisierung, Industrie 4.0, Quantencomputer und Digitalisierung. Auch die Debatte über versiegende Rohstoffe und Naturschutz ist keineswegs neu. Wer den Auszug aus dem SPD-Parteitagsbeschluss liest wird feststellen, dass umweltfreundliche Kernkraftwerke Strom aus Kohle ersetzen sollten. Die Forderung nach Kernkraftmaschinen entsprang der Vorstellung beschränkter Ressourcen. Ebenso nehmen die heutigen Bücher, Filme, Science-Fiction-Magazine und Diskurse bereits Kernfusion, Quantencomputer, usw. vorweg. Ähnlich wie in dem Moment, als Kernwaffen plötzlich eine reale Existenz erlangten, die Atombombe aber bereits Jahrzehnte zuvor ein Grundthema der spekulativen Literatur war, sind auch Kernfusion und Quantencomputer ein gut verstandenes Konzept und Teil der mentalen Karte vieler Menschen, wenn diese in Zukunft eine reale Existenz als Kernfusionkraftwerk und Quanten-Hochleistungsrechner erlangen.

Die Hyperenergiegesellschaft

Wenn man die deutschsprachigen „Qualitätsmedien“ verfolgt wundert man sich, dass die Industrialisierung durch eine Aufgabe von Wind und Bioenergie hin zur Nutzung von Kohle und Erdöl erfolgte. Bis zum Beginn der Neuzeit lebten die menschlichen Gesellschaften immer in Knappheit. Ihnen standen nur dünne Energieflüsse zur Verfügung: Ein bisschen Wind, ein bisschen Wasser, aber vor allem Holz und die Muskelkraft von Tieren und Menschen. Sklavenarbeit war die notwendige Folge und stets gegenwärtig. Denn die Flächen, die für Ackerbau, Viehzucht und Forstwirtschaft zur Verfügung standen, bildeten praktisch die einzige Energieressource. Damit waren politische Macht, gesellschaftlicher Status und ökonomischer Wohlstand eines Individuums unmittelbar mit dem Besitz von Land verknüpft. Die übergroße Mehrheit der Menschen, mit der Ausnahme von kleinen Eliten, lebte schlecht, kurz und in absoluter Armut. Die nutzbare Energie war zwar erneuerbar, erlaubte aber weder dauerhaftes Wachstum noch grundlegend bessere Lebensbedingungen.[7][8]

Als in der zweiten Hälfte des 18. Jahrhunderts die Wirtschaft mit Hilfe der alten Energiequellen nicht mehr weiterentwickelt werden konnte, änderte sich mit der industriellen Revolution die energetische Grundlage menschlicher Gesellschaften vollständig. Die Grenzen der Entwicklung, die der geringe Wirkungsgrad der Photosynthese definierte, wurden überwunden. Dampfmaschinen wurden zu neuen Arbeitstieren und ihre Nahrung wurde nicht mehr auf dem Acker, sondern wesentlich effektiver durch die verdichtete Sonnenenergie von Kohle, Erdöl und Erdgas gewonnen.[9][8] Später dann kam die Kernkraft hinzu, die die völlige Unabhängigkeit von der Launenhaftigkeit natürlicher Prozesse und der Zufälligkeit geographischer Gegebenheiten gewährleisten kann. Bis heute ist sie die einzige Energiequelle die es ermöglicht, auf dem Meeresgrund oder auf anderen Himmelskörpern Menschen anzusiedeln.[8]

Diese Entwicklung bedeutete eine Verschiebung der Macht, weg von den Landbesitzern hin zu den Produzenten, den Händlern und den Konsumenten. Das knappe Gut Energie, einst vom landbesitzenden Adel kontrolliert, wurde für jedermann zu jedem Zeitpunkt verfügbar. Es entstanden Wohlstand und freiheitliche, durchlässige Gesellschaften, in denen der Status des einzelnen nicht davon abhing, ob er in eine Familie von Landbesitzern hineingeboren wurde. Und es gab eine Perspektive anhaltenden Wachstums unabhängig von der territorialen Größe. Wissen, Kreativität und Innovationspotential entwickelten sich zu entscheidenden, unbegrenzt verfügbaren Ressourcen. Die Sklaverei konnte erst überwunden werden, als eine neue, überall in ausreichenden Mengen verfügbare Energiequelle für den Betrieb von Maschinen aller Art in die Menschheitsgeschichte eintrat.[10][11]

Derzeit decken fossile Energieträger etwa 85% des weltweiten Energiebedarfs. Aus gutem Grund, denn Erdöl, Erdgas und Kohle sind mittels geeigneter Technologie zu jedem Zeitpunkt preisgünstig verfügbar. Umweltschädliche Windmühlen und Solarzellen liefern nur unstetig, abhängig von Tag- und Jahreszeit, von launischem Wetter und sich wandelndem Klima. Hier setzt die Natur die Grenzen. Auf der anderen Seite gibt es mit Kernbrennstoffen noch bessere Energiespeicher. Verglichen mit fossilen Brennstoffen sind diese um Größenordnungen energiedichter. Sie übersteigen die der herkömmlichen Brennstoffe, ob nun Torf oder Holz, Erdgas oder Kohle, um mehrere Größenordnungen. Das macht sie zur Zukunftstechnologie. Vom Standpunkt menschlicher Entwicklung betrachtet bilden Kohle und Uran eine untrennbare Einheit. Ohne Industrialisierung durch die Kohle gäbe es heute keine Kernreaktoren, und Kernenergie ist der logische, natürliche Nachfolger der Kohle.[12][13] Nicht ohne Grund bekämpfen die Grünen beides mit Vehemenz: Mit diesen Energiespeichern konnte der Mensch dauerhaft dem Jammertal der erneuerbaren Ressourcen entkommen, in dem er seit Beginn seiner Existenz gesteckt hat.[13][14]

Kernenergie hat einiges zu bieten: Reaktoren sind sauber. Kein Rauch, kein Ruß, kein Feinstaub geht bei ihrem Betrieb in die Luft. Sie setzen weniger radioaktive Stoffe frei als Kohlekraftwerke. Sie sind kompakt, benötigen weit weniger Rohstoffe und Platz als die material- und landfressenden „grünen“ Energien. Sie liefern billigen Strom und das zu jedem Zeitpunkt. Von allen Kraftwerken haben Kernkraftwerke die höchste Verfügbarkeit. Kernenergie ist deshalb die passende Energiequelle für urbane Gesellschaften, für Städte, die niemals schlafen. Im Laufe dieses Jahrhunderts wird Kernenergie die Kohle mehr und mehr ersetzen – einfach deshalb, weil sie besser ist. Das ist technische Evolution: Das Bessere setzt sich durch, wenn nicht in Deutschland, dann woanders.[13]

Diese Entwicklung ist ein Segen für die Menschheit, da immer mehr Menschen die Errungenschaften des Industriezeitalters, wie ein gesundes und langes Leben, eine Klimaanlage und ein Auto geniessen können. Gerade im Sinne von Milliarden Afrikanern und Indern ist es zu wünschen, dass sich diese Entwicklung noch beschleunigt.

In den wohlstandsmüden Altindustriestaaten ist hingegen die Ökoreligion populär. Diese Religion propagiert eine verarmte, mittelalterliche Gesellschaft. Wohlstand für alle ist dieser Religion ein Graus. Gemäß den Glaubenssätzen dieser Religion führt das frevelhafte Tun der Menschen in den Weltuntergang durch "Endliche Rohstoffe" (70er Jahre), "Waldsterben" (80er Jahre), "Ozonloch" (90er Jahre) und aktuell durch den "Klimawandel" (2000ff). Gerade die Kernenergie mit dem ihr innewohnenden Potential, preiswerte Energie in unbegrenzter Menge überall verfügbar zu machen, bot sich den Misanthropen als ideales Ziel an. Als ökoreligiöser Gegenentwurf zur Technosphäre wurde das Konzept der „Nachhaltigkeit“ entwickelt.

Dabei ruft die Fokussierung auf die Vermeidung potentieller Zukunftsrisiken reale gegenwärtige Gefahren erst hervor. So bedeuten Technologieverbote, wie bei der Kernenergie, bei der Gentechnik oder beim Fracking ein Verzicht auf Innovationen, auf Wettbewerbsfähigkeit, auf Wertschöpfungsoptionen und damit auf künftigen Wohlstand.[15] So postuliert der Wissenschaftliche Beirat der Bundesregierung Globale Umweltveränderungen (WBGU) das Ende des „nuklearfossilen Komplexes“ und will stattdessen ein dezentrales System erneuerbarer Energiequellen. Deutschland, so kommentierte der amerikanische Politologe Walter Russell Mead, habe „im Grunde jede realistische Form der Energieversorgung für illegal erklärt, Atomkraft sowieso, aber auch Öl, Gas, Kohle“.[13][16]

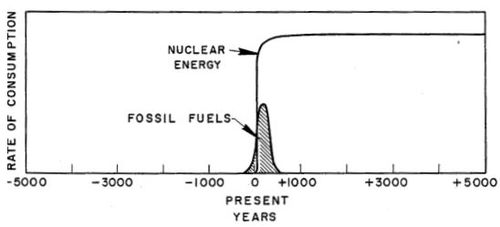

Langfristig gesehen sind Kohle, Öl und Erdgas Übergangstechnologien. Ihre Vorkommen sind endlich, und irgendwann wird sich ihre Förderung immer weniger lohnen. Sorgen muss man sich deshalb nicht machen: Kohle reicht noch für Jahrhunderte, Erdöl und Erdgas für mehrere Jahrzehnte. Ohnehin wird es kein abruptes Ende geben, sondern einen Übergang. Die Grafik links macht diesen Übergang deutlich. Sie stammt aus einem Fachartikel des amerikanischen Geologen M. King Hubbard, der in den 1950er-Jahren die Peak-Oil-Hypothese erfand.[12] Unübersehbar ist die einzigartige Rolle der fossilen Brennstoffe.[B] Die Kohle, zusammen mit Öl und Erdgas, beendete die Jahrtausende andauernde Energiearmut. Diese Brennstoffe führten die menschliche Zivilisation in eine Ära zuvor nicht vorstellbaren Reichtums – selbstverständliche Normalität in den Industrieländern heute. Die Nutzung der fossilen Brennstoffe ist ein singuläres Ereignis in der menschlichen Geschichte und ein Glücksfall. Mit der Kernenergie steht bereits der natürliche Nachfolger in den Startlöchern: „Natürlich“ deshalb, weil sie um Größenordnungen leistungsstärker ist. Damit lässt sich nicht nur das vorhandene Niveau halten, sondern mehr Menschen kann ein höherer Lebensstandard als heute gewährt werden. Kernenergie wird dann die Rolle einnehmen, die heute die Kohle hat. Allerdings werden Kohle und Kernenergie noch viele Jahrzehnte nebeneinander existieren. So können Hochtemperaturreaktoren Wärme liefern, um etwa Kohle in Treibstoff oder Synthesegas umzuwandeln.[13][12]

Nimmt die Zahl der Kernkraftwerke zu, dürfte immer weniger Kohle verfeuert werden, um Strom und Wärme zu erzeugen. Das macht Sinn, denn Kohle ist ein wichtiger Rohstoff für die chemische Produktion und die Stahlerzeugung. Wann die Dominanz der fossilen Brennstoffe zu Ende geht, ist schwer zu sagen. Vorhersagen eines baldigen Endes lagen bislang immer daneben. Letztlich ist der Zeitpunkt auch belanglos. Was zählt, ist, dass die fossile Ära mit der Kernenergie eine Energietechnologie hervorgebracht hat, die dank der Brütertechnik Energie im Überfluss und zeitlich unbegrenzt liefern kann.[13]

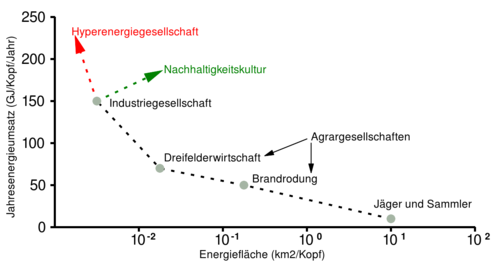

Im Gegensatz zur Propaganda der Nachhaltigkeitspropheten ist die moderne Welt nicht mit Konsum- oder Verhaltenszwängen verbunden. Es geht nicht darum, den ganzen Tag mit dem Auto zu fahren und dabei Burger verzehren zu müssen. Der Unterschied zu vergangenen Epochen besteht in der Möglichkeit, es zu können, wenn man denn möchte. Der Wohlstand eines Landes, dessen energetische Basis im wesentlichen Biomasse bildet, ergänzt durch Wind- und Wasserkraft sowie die Photovoltaik, hängt primär von den vorgefundenen geographischen und klimatischen Bedingungen ab, insbesondere von der verfügbaren Fläche fruchtbaren Ackerlandes. Missernten führen zu Energiearmut, und wer seinen Wohlstand mehren und die Versorgung der Bevölkerung verbessern will, ist zu einer territorialen Erweiterung gezwungen. Längst überwunden geglaubte imperialistische Vorstellungen über die Notwendigkeit zur Gewinnung von „Lebensraum“ könnten wieder aufkommen. In einer auf naturinvasive Energien angewiesenen Welt wäre die Hegemonie des Landbesitzes gegenüber allen anderen Konzepten des Wirtschaftens wieder etabliert. Die Grafik rechts stammt aus dem von der Bundesregierung abgesegneten WBGU-Konzept zur „Großen Transformation“. Sie verdeutlicht die mit der angestrebten „Nachhaltigkeitskultur“ einhergehende Senkung der Energieflächenproduktivität auf mittelalterliches Niveau. Die Folgen dieser Energiediät kann man sich ausmalen, in einem noch dazu weit dichter besiedelten Land mit weit höherem individuellen Energiebedarf.[10] Der Klimaschwindelpapst Hans Joachim Schellnhuber schreibt dazu in seinem Buch Selbstverbrennung: Die fatale Dreiecksbeziehung zwischen Klima, Mensch und Kohlenstoff, wo er auf den Spuren Wolfgang Harichs wandelt:[11]

- „Denkbar sind vor allem zwei vehement auseinanderstrebende Pfade, nämlich zum einen der Weg in die Hyperenergiegesellschaft, wo aus Quasi-Punktquellen (wie Kernfusionsreaktoren oder Kernspaltungsanlagen der übernächsten Generationen) auch pro Kopf immer mehr Energie verfügbar wird. Oder zum anderen die asymptotische Annäherung an eine Nachhaltigkeitskultur, wo sich der Jahresenergieverbrauch pro Kopf stabilisiert und sich der Fortschrittspfeil durch Nutzung von Sonne, Wind, Wellen und Erdwärme in die Fläche zurückbiegt.[C] Dadurch könnte allerdings viertens eine überaus problematische Bedarfskonkurrenz mit anderen Nachhaltigkeitszielen wie der zureichenden Versorgung der Weltbevölkerung mit gesunden Nahrungsmitteln oder der Bewahrung der Arten- und Landschaftsvielfalt entstehen. Wir stehen also in der Tat an einer epochalen Weggabelung und können dort nicht lange ratlos verharren. Wie man dieser dramatischen Herausforderung begegnen könnte, werde ich im dritten Teil (insbesondere Kapitel 27) skizzieren. Zuvor aber noch mal ganz langsam zum Memorieren: Mit der Nutzbarmachung der Kohle im großen Stil begann ein neues Wirtschaften, gestützt auf »Energiesklaven«, die dicht gedrängt im Untergrund bereitstanden. Während ein Mitglied einer Jäger-und-Sammler-Gesellschaft noch etwa das Drei- bis Sechsfache der menschlichen Grundumsatzenergie akquirierte (in Form von Fleisch, Holz etc.), kann jedes Individuum der Industriegesellschaft im Schnitt auf das 70- bis 100-Fache dieser metabolischen Größe zugreifen. Eine Riesenschar von fossilen Energiegeistern ist uns also zu Diensten, sobald wir kleine Schalter umlegen oder flache Tasten drücken. Nichts könnte weniger selbstverständlich sein, und doch erwarten die Menschen in den reichen Nationen genau dies von ihrem Alltag. Und mit der Blüte der Energiesklaverei wurde zwingend der Siegeszug des Industriekapitalismus in Gang gesetzt: Wer über das Geld verfügte, Produktionsanlagen zu erwerben, konnte dort mit den gleichermaßen käuflichen fossilen Ersatzarmeen Waren in ungeheuren Massen erzeugen, diese von den fossilen Transportgeistern in die weite Welt befördern lassen und Gewinne jenseits aller bekannten Grenzen anhäufen.“

Am Ende ist die Hyperenergiegesellschaft nicht nur die zwangsläufige Zukunft, sondern auch die attraktivere. Denn in der Technosphäre sind Gesellschaften robust gegenüber klimatischen Veränderungen, ganz gleich, ob die Warnungen der Klimawandelprediger eintreffen oder nicht.[10] Ein Leben in Wohlstand, umgeben von allerlei elektronischen Helferlein ist den meisten Menschen die erstrebenswertere Option, als in Dunkel und Kälte „nachhaltig“ in einer ökologischen Planwirtschaft zu frieren, oder das Auto wegen Flaute oder Missernte stehen zu lassen. Oder wie es Professor Hans Schimank in den Physikalische Blätter bereits 1954 in dem Beitrag Technik als formende Kraft unserer Zivilisation beschrieb:[17]

- „Denn über die Wohlgestalt und den Wertgehalt einer Gesellschaft und einer Kultur entscheidet nicht die Macht der Technik, sondern die Gesinnung und Gesittung von Völkern, die sich verantwortungsbewusst der Technik als ihres Werkzeuges bedienen. Ware ich ein christlicher Theologe, so wurde ich vielleicht formulieren: Gott prüft den Menschen durch die Technik auf die Echtheit seiner christlichen Demut und Liebe. Als Weltkind darf ich nur sagen: Der Mensch versucht sich an der Welt auf vielerlei Weise. Mittels der Technik aber ermisst er mit Genauigkeit Art und Güte seines Wesens und erprobt so die ganze Kraft des wahren Menschentums. Nicht in der Errichtung zyklopischer Bauten und nicht durch die Erfindung von Maschinen titanenhafter Starke feiert die Technik ihre höchsten Triumpfe. Sie darf sie erst feiern, wenn sie dem Menschen jene unvergleichlich kostbare Freiheit erkämpft hat, deren er zur Entfaltung seiner edelsten geistigen und seelischen Kräfte bedarf, die Freiheit, als selbstverantwortliche Persönlichkeit zu leben, tätig zu sein und sich zu entscheiden.“

Zeitalter

Aufbauend auf der von Geschichtsprofessor Matthew Lavine von der Mississippi State University gezogenen Linien zwischen den Atomzeitaltern, werden die einzelnen Zeitalter betrachtet. Zum ersten Atomzeitalter, von der Entdeckung der Radioaktivität bis zur Zündung der Bombe, ist nur sehr spärlich Fachliteratur vorhanden. Hauptwerke sind hier Lavine's Essay The First Atomic Age Scientists, Radiations, and the American Public, 1895–1945 und Spencer Weart’s Nuclear Fear: A History of Images, welches die Grundlage des Lemmas Strahlenangst bildet.

Für den Zeitraum des „Kalten Krieges“ ist hingegen massig Literatur vorhanden, über alle Aspekte der Nuklearkultur und Technik. Leider leiden fast alle diese Betrachtungen unter einer Fixierung auf Kernwaffen, oder beschwören das Ende des Atomzeitalters. Da sich die heutige Soziologie als linke Kampfwissenschaft von den Prinzipien der Wissenschaft selbst verabschiedet hat, ist dies nicht weiter verwunderlich.[18][19][F] Empfehlenswert sind hier die Bände des Druckwerkes Das neue Universum, das zumindest bis in die 70er Jahre hinein einen ökologismusfreien, und damit fortschrittsfreundlichen Blick auf die Welt bot.

Für das letzte Kapitel wird ein Ausblick in die Zukunft gewagt. Die Stichworte dazu stammen aus den Bänden der Verlagsreihe Das neue Universum, dem Buch Zukunft – Das Bild der Welt von morgen (1974) und das in der sogenannten „DDR“ herausgegebene Werk unsere welt von morgen (1960). Diverse von Fachleuten und Wissenschaftlern veröffentlichte Studien flossen ebenfalls mit ein.[G]

Erstes Atomzeitalter

Als Radioaktivität das Licht der Öffentlichkeit betrat, war dies in der Geschichte der modernen Wissenschaft ein Novum: Zu dieser Zeit wurden einige fundamentale wissenschaftliche Erkenntnisse gemacht, zum Beispiel Massenkommunikation durch elektrische Leiter, Elektrizität für Licht und Kraftmaschinen, Verbrennungsmotoren, Flugzeuge, chirurgische Eingriffe unter Betäubung und Keimtötung, synthetische Chemie, die Erkenntnis der Plattentektonik und damit des Alters der Erde, und viele weitere Wunder der Technik, die die Gesellschaft disruptiv veränderten. Alle diese Dinge wurden der massenmedialen Öffentlichkeit als vollendete Tatsachen präsentiert. Die Entdeckung von Strahlung, die aus evakuierten Röhren entwich, war hingegen ein Mysterium. Physiker und Chemiker konnten diese Erscheinung nicht schlüssig erklären, und in diesem Fall war die Öffentlichkeit über die Massenmedien quasi live in die wissenschaftliche Debatte eingebunden. In diesem Interregnum der Physik und Chemie um die Jahrhundertwende bekam die Esoterik aufwind,[5] denn die Esoterik hängt an der Physik wie Parasiten an einem Wirtstier.

Die frühste Erwähnung von Röntgenstrahlen in der US-amerikanischen Presse war ein Fake-News-Artikel in der Chicago Daily Tribune 1896.[D] Neben andern Presseorganen erschien einige Wochen später in der Tribune ein Artikel über die potentielle industrielle Anwendung der Röntgenstrahlen, ein paar Tage später ein Artikel über wissenschaftliche Theorien über die Strahlen, und ein paar Tage später ein Artikel in dem darüber spekuliert wurde, Röntgenstrahlen seien eine Verbindung in die Geisterwelt. Im gleichen Jahr wurden von Becquerel auch Röntgen-ähnliche Emissionen des Urans entdeckt. Marie Curie prägte dafür den Begriff Radioaktivität. Das Problem, das Radioaktivität die damals bekannten Gesetze der Physik verletzte kam 1903 wieder in den Fokus. Becquerel und die beiden Curies bekamen den Nobelpreis, und im Juni wurden Soddys und Rutherfords Entdeckungen zur Transmutation bekannt. Etwas später wurden Röntgenstrahlen und Radium als Mittel zur Krebsbekämpfung einer weiten Öffentlichkeit bekannt, und begonnen Röntgenaufnahmen zu medizinischen Zwecken zu machen. In dieser Zeit wurden von den Qualitätsmedien auch diverse Fake News verbreitet, wonach Radioaktivität Blinde wieder sehen lassen könne und ähnlich sensationelles. Sie stimmten damit in den Chor diverser Wissenschaftler ein, die dramatisierend die Unsicherheit betonten, die die Entdeckung von Röntgenstrahlung und Radium in die Physik und Chemie brachten.[5]

Frederick Soddy beteiligte sich daran, als er 1909 sein populäres Buch The Interpretation of Radium vorstellte. Das Buch erhielt begeisterte Kritiken, wurde in vier Editionen im Laufe der nächsten 11 Jahre gedruckt. Soddy, dadurch ermuntert, schrieb weitere Bücher über Atomstrukturen und die darin gebundenen Energien. H. G. Wells widmete seinen 1914 erschienenen Roman The World Set Free, der von einem Atomkrieg handelt, Soddy, indem er Charaktere in dem Roman aus The Interpretation of Radium paraphrasieren ließ. Soddy revanchierte sich, indem er 1915 die mediale Öffentlichkeit vor den Gefahren eines Atomkrieges warnte. Science-Fiction- und Populärliteratur griffen das Thema Radium und Radioaktivität auf.[5]

Um die Jahrhundertwende wurde auch festgestellt, dass diverse Grundwässer, besonders solche die tief und heiß aus der Erdkruste kamen, radioaktiv waren. Dies verstärkte den Eindruck der damaligen Zeit, welcher Radioaktivität mit Vitalität und Gesundheit verband. Geschichten über Heilerfahrungen und Indianerlegenden an diversen Quellen wurden bald als Beleg für deren Radioaktivität genommen. Heilbäder nutzen diese neue Entdeckung, um für sich zu werben: Die Radonheilbäder entstanden. Ab 1910 kamen dann diverse Tuben, Salben, Pillen, Kleidung, Krüge, Emanatoren und anderes Zeug auf den Gesundheits- und Schönheitsmarkt, das zumindest der Verpackung nach radioaktiv sein sollte. Es wurde damit geworben, dass die Strahlen, den Strahlen der Sonne gleich, die Zellen des Körpers wieder mit Energie aufladen würden.[E] Die Produktpalette wurde um Radiumfarben erweitert, die im Dunkeln selbst leuchten. Um 1920 waren viele Haushalte noch nicht an das Elektrizitätsnetz angeschlossen, sodass selbstleuchtende Schlüssellöcher, Schalter, Uhrenziffern usw. attraktiv waren.[5]

Radioaktivität war damals ein kulturelles Phänomen, und stand für Fortschritt, Gesundheit und Modernität. So wie heute alles Öko, Bio und Grün sein muss, musste damals alles radioaktiv sein. Die Federal Trade Commission (FTC) prüfte bereits damals diverse Radium-Emanatoren. Die meisten enthielten gar kein Radium oder sonstige Radioaktivität, und diejenigen die tatsächlich radioaktiv waren, enthielten weit weniger Radioaktivität als angegeben. Auch radioaktive Tinkturen wurden vom Department of Agriculture geprüft, wobei manche, wie Radol, nicht radioaktiver als normales Leitungswasser waren.[5] Analog zu „Greenwashing“ könnte man von „Yellowwashing“ sprechen.

Gegen Ende des ersten Atomzeitalters kamen Konzepte auf, die heute vertraut sind. Bereits 1934 hatte sich der ungarische Physiker Leó Szilárd die Idee eines Apparates, der eine nukleare Kettenreaktion bei Überschreitung einer kritischen Masse zur Energiegewinnung ausführt, patentieren lassen.[20] Die Kernspaltung wurde im Dezember 1938 am Kaiser-Wilhelm-Institut für Chemie entdeckt. Otto Hahn und sein Mitarbeiter Fritz Straßmann bestrahlten Uran mit Neutronen und stellten dabei fest, dass offenbar auch Spaltprodukte wie Barium entstanden waren. Im Jahr 1939 veröffentlichte das US-Magazin Amazing Stories einen Artikel über zukünftige Atomic Power Plants, die unbegrenzt Energie zur Verfügung stellen sollten. Es handelt sich wahrscheinlich um das erste skizzierte Konzept, Kernenergie zur Stromgewinnung zu nutzen. 1942 wurde Fermis Chicago Pile, der erste Atommeiler der Welt, kritisch. Fermi baute 1944 den ersten Flüssigkernreaktor, in dem Uranylsulfat in Wasser gelöst wurde. Das uransalzhaltige Wasser wurde in einem kugelförmigen Tank, der von einem Neutronenreflektor aus Berylliumoxid umgeben war, kritisch. Damit konnte die kritische Masse von Uran-235 bestimmt werden.[21]

Durch das Manhattan-Projekt gefördert und entwickelt, explodierte am 16. Juli 1945 um 5:29:45 Uhr Ortszeit in den USA die erste Kernwaffe der Welt. Die Testwaffe, eine Plutonium-Implosionsbombe, wurde auf einem 30,5 Meter hohen stählernen Turm in der White Sands Proving Grounds im US-Bundesstaat New Mexico gezündet. Einen Monat später wurden die ersten Kernwaffen auf Hiroshima und Nagasaki abgeworfen. Damit endete nicht nur der Zweite Weltkrieg, sondern auch das erste Atomzeitalter. Milton Rothmar, Science-Fiction-Autor und in Italien stationiert, schrieb dazu im Oktober 1945:[5]

- „It was in The Stars and Stripes this morning, and even though I had been expecting it ever since hearing the first guarded stories from here and there concerning “Tennessee”, the reality was hard to believe. The headline said “Atomic Bomb”. To a person who has been raised on stories such as “The Final War”, this was both a terror and a hope. Man could use this to destroy everything. He could also be scared so badly at its possibilities that impending wars would be staved off long enough for a world organization to get going properly. My own personal hope: that I can get home fast enough and get my Doctor’s degree quickly enough so as to be able to get into the middle of the work that will be going on to slow down the atomic explosion and put it into a rocket motor. . . . When we stopped a few minutes at Rome, I heard somebody say on the radio the same remarks concerning the good and evil of atomic energy that I wrote above. It is obvious that many people are saying the same things and, in fact, we science fiction readers have been saying them for years. Goddam but it is thrilling to hear the words “atomic energy” used on the radio like they were talking about the latest model car. I feel like shouting to everybody “I told you so!”“

Zweites Atomzeitalter

- „In den Geschichtsbüchern späterer Generationen wird der 27. Juni 1954 als der Tag vermerkt sein, an dem das „Atomzeitalter“ begonnen hat. Nicht die erste Urankernspaltung durch Hahn und Straßmann, nicht der erste Atombrand in Chicago, auch nicht die Zerstörung der Städte Hiroschima und Nagasaki leiteten dieses neue Zeitalter ein, sondern das Anlaufen des ersten Atomkraftwerkes der Welt.“[22]

Menschen haben über Zehntausende von Jahren auf Grundlage „erneuerbarer“ Energien existiert: in geringer Zahl, mit niedriger Lebenserwartung, abhängig von Naturgewalten, mit einem relativ angenehmen Leben nur für wenige, für die Mehrzahl ein steter Überlebenskampf. Mit Energieträgern hoher Energiedichte (Kohle, Erdöl, Uran) konnten sich menschliche Gesellschaften aus der Begrenztheit dünner biosphärischer Energien (Sonne, Wind, Wasser, Biomasse) lösen. Im Zuge der Industriellen Revolution entstand die energieintensive Technosphäre, die großen Teilen der Menschheit inzwischen ein langes und angenehmes Leben ermöglicht.[14] Als 1851 mit der Great Exhibition die erste Weltausstellung eröffnet wurde, konnten Besucher die Ursache ihres Fortschrittes bewundern: Dort wurde ein massiver, 15 Tonnen schwerer Klumpen Steinkohle aus Südwales ausgestellt, als Monument des Industriezeitalters.[23]

Als 1958 mit der Expo 58 die erste Weltausstellung nach dem Krieg in Belgien unter dem Motto „Technik im Dienste des Menschen. Fortschritt der Menschheit durch Fortschritt der Technik.“ eröffnet wurde, wurden die beiden neuen Zukunftstechnologien Raumfahrt und Atomkraft erstmals einer breiten Öffentlichkeit vorgestellt. Um den Leistungsstand der belgischen Stahlindustrie zu demonstrieren, entwarf André Waterkeyn das Atomium als Symbol für das Atomzeitalter und die friedliche Nutzung der Kernenergie. Im Inneren der Kugeln befanden sich Ausstellungen zum Thema Kernkraft, und in der obersten Kugel ein Restaurant mit Aussicht über das Ausstellungsgelände. Die Verheißung einer nach menschlichen Maßstäben unbegrenzten Energiequelle mit hoher Energiedichte beflügelte die menschliche Phantasie: Nuklear angetriebene Schiffe, Flugzeuge, Lokomotiven und sogar Autos und Raumschiffe wurden prophezeit, um das Industriezeitalter in die Zukunft zu führen.

Das Ende des Zweiten Weltkrieges war aber auch durch die Hochphase der sozialistischen Bedrohung gegen die freie Welt gekennzeichnet. Als die deutsche Reichsregierung 1917 mit Propaganda und deutschen Steuergeldern Wladimir Iljitsch Uljanow (Kampfname: Lenin) zur russischen Oktoberrevolution verhalf,[24] und damit den Spaltpilz des Sozialismus aus der Gosse auf die weltpolitische Bühne hievte, breitete sich dieser in den 1920er und 1930er-Jahren durch den Revolutionsexport der Kommunistischen Internationale weiter aus.[25] Die Anti-Hitler-Koalition seit 1941 überdeckte den Konflikt zeitweise. In der Nachkriegszeit, dem sogenannten „Kalten Krieg“, steigerte sich der Konflikt in ein Wettrüsten zwischen den USA und der 1949 gegründeten NATO auf der einen, und der Sowjetunion und dem Ostblock auf der anderen Seite, welches bis zur Selbstauflösung des Warschauer Pakts Anfang der 1990er Jahre anhielt.

Hauptwaffe der politischen Rhetorik, war neben „Menschenrechten“, „Freiheit“ und „sozialer Gerechtigkeit“ „Die Bombe“. Zwar hatten die USA anfangs die Nase vorne, wie der erste Kernwaffentest Trinity zeigte. Auch durch die Spionagetätigkeit der Kommunisten Klaus Fuchs, und Julius und Ethel Rosenberg konnte die Sowjetunion bereits 1949 nachziehen, was zu einem beispiellosen nuklearen Wettrüsten führte. Bemerkenswert war auch die erstmalige Entwicklung einer funktionsfähigen Interkontinentalrakete durch die Sowjetunion – der sogenannte Sputnik-Schock von 1957. Im Bereich der Massenvernichtungswaffen wurde zunächst vor allem die Zahl und die Sprengkraft der Kernwaffen erhöht. Die Entwicklung der thermonuklearen Waffen, umgangssprachlich Wasserstoffbombe genannt, zeigte am 9. Mai 1951 erste Erfolge, als ein Sprengkörper mit 225 Kilotonnen das Konzept bestätigte. Ein Jahr später, am 1. November 1952, zeigte die Teller-Ulam-Konfiguration mit dem Sprengsatz "Ivy Mike" ihr Potential: Mit einer Sprengkraft von 10,4 Megatonnen war das Gerät über 450 Mal stärker als die Bombe, die über Nagasaki abgeworfen wurde.

Die sozialistische Agitation gegen (westliche) Kernwaffen führte zur sogenannten „Friedensbewegung“.[H] Ferner entstand bereits mit Beginn der Industrialisierung mit der Steinersche Lehre, der Reform- und Jugendbewegung, der Reformkost und ähnlichen Weltverbesserungsideen eine Gegenbewegung, welche den Menschen in einen „natürlicheren“ Zustand zurückversetzen wollte. Dazu kam, dass nach dem Weltkrieg der kulturelle Marxismus der Frankfurter Schule um Habermas, Marcuse und Adorno den ökonomischen Marxismus bei den westlichen Linken an Beliebtheit ablöste. Mit seiner Kritik an der bürgerlichen Gesellschaft, einschließlich ihrer Herrschaftsstrukturen und sogar gegen ihr Bekenntnis zu Technologie und Rationalität, prägt er die heutige westliche Linke. Auf diesem geistigen Nährboden wuchsen eine Reihe von NGOs und anderer Pressure Groups, sowie die 68er-Bewegung, die in ihrem Marsch durch die Institutionen die meinungsgebenden Eliten in Deutschland porentief unterwanderte. Zur Dauerbeschallung durch links-grüne Tröten gehörten auch die Unkenrufe der Organisation Club of Rome, das fiktive Waldsterben und die Dramatisierung einer Reihe von Chemieunfällen (z.b. das Sevesounglück 1976, oder die Itai-Itai-Krankheit). Dies führte bei vielen Menschen in den westlichen Ländern zu einem Gefühl des Unbehagens, zu Schuldkomplexen und Katastrophentheorien gegenüber der modernen Technik und der weißen, westlichen Gesellschaft.

Ein Dokument des Wandels ist zum Beispiel das Buch Zukunft – Das Bild der Welt von morgen (1974). Alle in diesem Buch dargestellten Probleme einer zukünftigen Menschheit entsprechen dem ökologistischen Schema, in der Form einer Reihe von Weltuntergangs- und Endzeitvorhersagen. Das Narrativ war zu diesem Zeitpunkt bereits in der Hand der links-grünen Meinungsmacher. Im Unterschied zu heute waren die naturwissenschaftlichen Milieus der Ingenieure und Forscher aber noch die bürgerlich-technokratischen der Nachkriegszeit. Der Kontrast von ökoreligiösem Problembewusstsein auf der einen Seite, und nüchtern-sachlicher technischer Problemlösung auf der anderen Seite machen das Buch für jeden Interessierten der Gesellschaftsgeschichte zur Pflichtlektüre – auch um einen ökologiefreien Blick in die Zukunft zu gewinnen.[26]

In der konkreten technischen Implementierung wurden Kernkraftwerke als erstes angegangen: So wurde ab 1949 der Experimental Breeder Reactor I in der National Reactor Testing Station (heute Idaho National Laboratory) gebaut. Am 20. Dezember 1951 konnte erstmals Atomstrom produziert werden, indem vier 200-W-Glühbirnen zum Leuchten gebracht wurden. Ab 1952 wurden in der National Reactor Testing Station auch die BORAX-Experimente durchgeführt. Diese Experimente sollten zeigen, das mit Siedewasserreaktoren ein stabiles Betriebsverhalten möglich war, was von dem Nukearingenieur Samuel Untermyer vorhergesagt wurde. Als BORAX-III am 17. Juli 1955 an das örtliche Stromnetz angeschlossen wurde, konnten 2.000 kWe für die nahe gelegene Kleinstadt Arco, 500 kWe für Idaho, 500 kWe für das BORAX-Testgelände und 1.000 kWe für die National Reactor Testing Station produziert werden. Arco wurde damit die erste Stadt der Welt, welche zu 100% mit Atomstrom versorgt wurde. In der Sowjetunion wurde das Kernkraftwerk Obninsk am 26. Juni 1954 in Betrieb genommen. Es war auch das erste Kernkraftwerk am öffentlichen Netz. 1957 folgte schließlich der kommerzielle Durchbruch der Atomkernenergienutzung: Das Kernkraftwerk Vallecitos wurde als erstes privat finanziert, gebaut und betrieben. Die Anlage wurde auch zur Ausbildung der Operatoren für das Kernkraftwerk Dresden verwendet, welches als Erstes ohne staatliche Zuschüsse gebaut wurde. Die Technik war damit marktreif, nachdem die Unikate der ersten Generation aufgrund ihres experimentellen Charakters und den höheren Produktionskosten nicht mit Kohlekraftwerken konkurrieren konnten.

Als der Club of Rome im Jahr 1972 seinen ökoreligiösen Verzichtsappell „Die Grenzen des Wachstums“ veröffentlichte, und ein Jahr später das Ölembargo arabischer Staaten die Bürger „westlicher“ Länder traf, wurde die Kernenergienutzung in allen Ländern als Lösung des Problems angesehen. Das Schreckgespenst, dass eines Tages durch einen Mangel an fossilen Brennstoffen die Technosphäre durch eine energieoptimierte Erziehungsanstalt ersetzt werden müsse, sollte so verhindert werden. Kernenergie sollte fossile Brennstoffe zunehmend ersetzen und Energie für die Industrialisierung der armen Länder liefern. Europäische Länder forcierten die Kernenergie, um sich von ausländischen Energielieferungen unabhängiger zu machen. Entwicklungsländer wie Indien, Iran, Pakistan, Brasilien und Argentinien legten ehrgeizige Programme zum Bau von Kernreaktoren auf. 1981 veröffentlichte ein internationales Wissenschaftlerteam das erste globale Energieszenario unter dem Titel „Energy in a Finite World: Paths to a Sustainable Future“.[27] Es projektierte eine Weltenergieversorgung, die auf Kernreaktoren und großen Solarkraftwerken in Wüstengebieten beruhte. Weltweit sollten nach dieser Studie zur Jahrtausendwende rund 1600 Reaktoren in Betrieb sein, rund 3600 im Jahre 2020.[13] Weitere angedachten Systeme wie nuklear angetriebene Raumschiffe, Autos, Flugzeuge und Schiffe konnten zumindest technisch verwirklicht werden. Die Massenanwendung scheiterte meist an politischen und wirtschaftlichen Gründen. Einen beispiellosen Aufstieg erlebte neben den Kernkraftwerken auch die Anwendung von Radionukliden in der Nuklearmedizin, der Mutationszüchtung und der Materialforschung.

Mit dem Ende des sogenannten „Kalten Krieges“ begann nach der Einteilung von Geschichtsprofessor Matthew Lavine das Ende des zweiten Atomzeitalters. Die mentale Karte wandelte sich: Das Gleichgewicht des Schreckens, spektakuläre Bilder von explodierenden Kernwaffen und die Logik des Wettrüstens spielten nach dem „Wind of Change“ im Osten keine Rolle mehr. Heutige Bürger assoziieren mit „Atom“ andere Bilder als ein Bürger auf dem Höhepunkt der Blockkonfrontation.

Drittes Atomzeitalter

- Lieber Herr Selbstversorger!

- Offenbar ist Ihnen nicht bewusst, wie wir unseren Strompreis kalkulieren. Sie zahlen keineswegs für ‚den Strom‘ allein, sondern vor allem für die Baukosten unseres Kraftwerks und die Kosten der Leitungen, die wir unterhalten müssen. Von den 15 Cent, die Sie uns pro kWh bezahlen, verbrauchen wir nur 2 Cent für die tatsächliche Herstellung des Stroms, also für den Einkauf der Kohle, die wir im Kraftwerk verbrennen. Der Rest von 13 Cent geht in die Instandhaltung, die Abschreibung und die Verzinsung und ein bisschen Gewinn wollen wir auch haben, sonst können wir ja gleich aufhören.

- Sie zahlten uns bisher 1500 € im Jahr. Dafür bekamen Sie 10.000 kWh. Nun sieht es so aus, als würden Sie nur noch die Hälfte beziehen wollen, aber trotzdem jederzeit die volle Leitung wie früher verlangen. Wir müssen also unser Kraftwerk und die Leitungen genau so bereit halten wie bisher. Deshalb haben wir auch weiterhin fixe Kosten von 1300 €, die von Ihnen verursacht werden. Wir sparen zwar Brennstoff, wenn Sie nur die Hälfte abnehmen, aber das sind nur 100 €. Wenn Sie also nur noch 5000 kWh beziehen wollen, sehen wir uns gezwungen, den Preis pro kWh auf 28 Cent zu erhöhen – sonst müssten wir unseren Preis für alle Kunden erhöhen, um unsere Kosten zu decken und das können wir Ihren Nachbarn nicht zumuten.

- Mit freundlichen Grüßen

- Ihr Versorger[28]

Bei der Betrachtung der globalen Strompreisentwicklung (oder allgemeiner: Energiepreisentwicklung) lässt sich folgender Trend feststellen: Die Energiepreise sinken seit Jahrhunderten. Um den Preis für eine Stunde Leselicht bezahlen zu können, musste ein durchschnittlich verdienender Brite 1997 etwa eine halbe Sekunde arbeiten. 1950 wären dafür acht Sekunden Arbeit vonnöten gewesen, 1880 fünfzehn Minuten und um 1800 hätte ein Arbeiter sechs Stunden seiner Zeit investieren müssen, um sich eine Kerze zu leisten, die eine Stunde gebrannt hätte.[29] Inzwischen ist der Trend soweit fortgeschritten, das Strom ein typisches Flatrate-Produkt ist.[28] Bei einem Endverbraucherpreis von unter 15 ct/kWh liegen die Erzeugungskosten von Wasser-, Kern- und Kohlestrom in den USA bei 1 – 3,5 ct/kWh, wobei die Brennstoffkosten von Kernkraftwerken bei 0,6 ct/kWh liegen (inkl. 0,1 ct/kWh Entsorgungsabgabe).[30] Zu beachten ist nun, dass alle Kosten ausser den Brennstoffkosten Fixkosten sind. Wenn ein Abnehmer nichts abnimmt, aber sich das Recht vorbehält, jederzeit Strom bis zur vertraglichen Grenze seines Anschlusses zu beziehen, muss der Versorger die volle Kraftwerks- und Netzkapazität jederzeit vorhalten und natürlich die entstehenden Kosten tragen. Dies führt zu der paradoxen Situation, dass ein sinken des Stromverbrauches zu einer Erhöhung des Strompreises führt. Damit wird Strom zum Flatrate-Produkt: Weil wie beim Internet die Benutzung der Leitung gegenüber den Infrastrukturkosten kaum ins Gewicht fällt, zahlt der Kunde einen Fixpreis und kann dann bis zum Anschlussgrenzwert so viel verbrauchen wie er will. Zumindest wäre es aber aufgrund der Kostenstruktur richtig, eine sehr hohe Grundgebühr und einen sehr niedrigen kWh-Preis zu verlangen.[28]

Elektrische Energie wird – mit oder ohne Deutschland – in Zukunft zunehmend in Kernkraftwerken erzeugt werden. Diese Entwicklung ist in einer freien Wirtschaft zwingend, weil Kernenergie inzwischen sicher beherrschbar ist und neben großen Wasserkraftwerken die niedrigsten Kosten verursacht.[31] Würde der Strom sehr billig bzw. per Flatrate bezogen, würden viele Menschen dazu übergehen, elektrisch zu heizen und Elektroauto zu fahren. In der Industrie und Produktion würden mehr Tätigkeiten durch Maschinen erledigt, was zu einem Entwicklungsschub bei Automation und elektronischen Rechenmaschinen führt. Diese Vollautomatisierung führt, zusammen mit der Verfügbarkeit von preisgünstiger Energie zur Welt der Zukunft.[9]

Vollautomatisierte Fabriken, in denen kein Mensch mehr arbeitet produzieren Güter. Neue Aufbereitungsfabriken würden Abfall wiederverwerten, um daraus wieder Rohstoffe zu gewinnen. Schwimmende Kernkraftwerke werden gebaut, um auch entlegene Regionen flexibel mit Atomkernenergie versorgen zu können. Bergbau würde auch auf dem Meeresgrund betrieben. Selbstfahrende Automobile mit Elektromotoren, möglicherweise über Induktionsschleifen in der Fahrbahn aufgeladen surren durch die Gegend.[26][9] Geräuschlose Magnetschwebebahnen werden gebaut, um mit Tempo 500 zu reisen. Magnetschwebetechnik käme auch bei der Straßenbahn oder Schienentaxis zum Einsatz, um das Gequietsche bei der Kurven- und Geruckel bei der Weichenfahrt abzustellen.[26]

Zur Ernährung der zukünftigen 15 Milliarden Erdenbürger werden Pflanzenfabriken bzw. Farmfabriken in klimatisierten Gebäuden Nahrungsmittel züchten. Aquakulturen werden verstärkt eingesetzt, um die Produktivität der Fischerei zu verbessern.[26][9] Da die Aufzucht eines Tieres zeit- und kostspielig ist wurde in den 70er Jahren auch daran geforscht, Fleischersatzprodukte aus Soja, oder aus Erdöl mit Hilfe von Mikrobenmasse herzustellen.[26]

Besondere Aufmerksamkeit liegt auf der Stadt der Zukunft. Diese muss natürlich autofreundlicher werden, indem die Straßen verbreitert, getunnelt und aufgeständert werden. Automatische Parkhäuser werden Standard. Angedacht waren auch Städte unter einer Plexiglaskuppel, die mit Kernkraft klimatisiert werden. Durch künstliche Beleuchtung kann der Tag-Nacht-Rhythmus abgeschafft werden. Um die Natur zu schonen, wurden diese Ideen in andere Stadtkonzepte hineinentwickelt: Bei sogenannten Kathedralen-Städten oder Hochhaus-Städten besteht die ganze Stadt aus einem einzigen Gebäude, oder einem Ensemble von miteinander verbundenen Hochhäusern. Die Stadt steht dann wie eine Raumstation in der Landschaft ohne sie zu verschmutzen, da alle schädlichen Gase, Flüssigkeiten und Feststoffe abgesaugt, isoliert und weiterverarbeitet werden. Ein solches Stadtsystem kann überall errichtet werden, selbst in Eis und Wüste.[26][9] Eine Ideenskizze zeigte beispielsweise, wie die Bewohner von Los Angeles in vier 500m hohen Hochhäusern untergebracht werden könnten, mit 22.000 Bewohnern pro Turm. Die umgebende Landschaft kann dann der Natur überlassen werden. Weitere Ideen gehen von Hochhaus-Städten im flachen Wasser der Küsten aus, um Landfläche zu schonen. Die Verbindung zwischen den Hochhäusern bzw. Bewohnern und ihren Einkaufs- und Arbeitsstätten fände dann durch Fahrstühle und Rohrpostsysteme statt. Im Fuß der Türme ist dann unter der Erde der Fernbahnanschluss, und das Parkhaus für die Autos der Bewohner untergebracht.[26]

Diese Art des umweltfreundlichen siedelns wurden vom italienischen Physiker und Systemanalytiker Cesare Marchetti auf die Spitze getrieben, als er 1979 ein Paper mit dem Titel 1012: A Check on the Earth-Carrying Capacity for Man veröffentlichte. Sein Szenario war eines von vielen Papieren, die er am Internationalen Institut für angewandte Systemanalyse (IIASA) in Laxenburg bei Wien verfasste. Marchetti war Mitautor des ersten globalen Energieszenarios „Energy in a Finite World“. In dem Paper beschreibt er, mit überschlägigen Rechnungen untermauert, wie eine Billion Menschen auf der Erde leben könnten, wenn diese in Kathedralen-Städten (teilweise auch aufgeständert im Meer wie Bohrinseln) leben würden.[32]

Alle Energie stammt aus nuklearen und solaren Quellen. Der gesamte Energieverbrauch wird sich auf 10.000 Terawatt belaufen. Das entspricht grob dem gegenwärtigen Energieverbrauch pro Kopf in Europa und den USA. Absolut gesehen wird der zukünftige Energieverbrauch pro Kopf also etwa gleich dem heutigen sein. Allerdings wird diese Energiemenge durch eine höhere Energieeffizienz einen zehnmal größeren Nutzen liefern als heute. In Marchettis Szenario wird ein Teil der Sonnenenergie, die auf die Stadtmaschinen fällt, lokal für Beleuchtung, Gebäudeklimatisierung und Stromerzeugung genutzt. Die industrielle Fertigung, einschließlich der Herstellung von Nahrungsmitteln, benötigt am meisten Energie. Diese kommt aus Brutreaktoren, denn mit der Brütertechnologie ist auch Uran aus Meerwasser wirtschaftlich einsetzbar. Konzeptionell bleiben so tausende Jahre der Kernspaltung, bis die Kernfusion aufgrund des Mangels an Brutstoffen benötigt wird. Güter und Menschen werden mit Magnetbahnen transportiert. Diese gleiten in unterirdischen Vakuumröhren mit Geschwindigkeiten über 500 Stundenkilometer. Für jeden Bewohner der Superstadt war eine Vielzweckverbindung (Supervideophon) zu jeder anderen Person, zu jeder öffentlichen Einrichtung und zu jedem öffentlichen Informationsspeicher angedacht. Jeder Person sollte ein Datenfluss von einem Terabit pro Sekunde (137 GB/s) zur Verfügung stehen.[32]

Das Konzept von Marchetti deckt sich mit den Ideen von Architekten und Physikern der Zeit. Die Idee war und ist stets, die Technosphäre zu kompaktieren und schärfer von der Natur zu isolieren. Diese Entwürfe gehen fließend in die Idee freier Privatstädte über. Freie Privatstädte haben einen Betreiber, der mit den Bewohnern als Staatsdienstleister einen Bürgervertrag auf Gegenseitigkeit abschließt.[33]

Anwendungsfälle

Stromversorgung

Jahrhundertelang hatte sich der Energieverbrauch nicht wesentlich geändert. In dem Jahrhundert von 1850 bis 1950 stieg er auf das Vierfache. Gleichzeitig nahm die Energieeffizienz zu: Die Produktion erhöhte sich in noch schnellerem Tempo, denn der Mensch lernte die Energie immer besser auszunutzen und rentabler zu verwenden. In den ersten fünf Jahrzehnten des letzten Jahrhunderts ist der Nutzwert der Energie auf das Doppelte angewachsen. Aber auch die Bevölkerungszahlen wuchsen. Dazu kamen ständig steigende Bedürfnisse der Menschen.[9]

Von den knapp 8 Milliarden Menschen auf der Erde streben etwa 6 Milliarden Menschen einen Lebensstandard analog der US-Mittelklasse an. Etwa 400-500 Mio. wünschen im Sinne der Ökoreligion eine Rückentwicklung in eine verarmte, feudalistische, vorindustrielle Gesellschaft. Insofern wird der Energiehunger der Welt von morgen ungleich größer sein als heute. Die enorme Ausweitung der automatisierten Produktion, die Entlastung des Menschen von allen schweren körperlichen Arbeiten und die Übernahme zahlloser Kontroll- und Steuerungsaufgaben durch Maschinen, die Überwindung von Armut und Rückständigkeit in bevölkerungsreichen Ländern, all das wird den Energiebedarf in die Höhe treiben. Dieser Energiebedarf wird hauptsächlich durch elektrische Energie gedeckt werden, denn sie ist am flexibelsten:[9] Sie treibt Maschinen und Automaten an, sie kann zum Heizen und zum Kühlen verwendet werden, für Mobilität und Beleuchtung. Ferner kann sie mit geringen Verlusten in andere Energieformen gewandelt, und gut transportiert werden. Der zunehmende Bedarf nach Elektromobilität wird die Nachfrage nach Strom weiter steigen lassen, besonders Nachts, wenn die Akkumulatoren geladen werden. Dies erhöht den Bedarf nach Grundlaststrom, und bevorzugt die Errichtung von Kraftwerken mit hoher Verfügbarkeit und geringen Brennstoffkosten.[34]

In einem Stromnetz müssen Einspeisung und Verbrauch in jedem Augenblick gleich sein. In einem modernen Stromversorgungssystem sichern die rotierenden Massen der Turbogeneratoren der Großkraftwerke die Stabilität im Sekundenbereich, die Kesselreserven der Dampfkraftwerke im Minutenbereich. Darüber hinaus kommen schnell ansprechende Reservekraftwerke zum Zuge, in der Regel sind dies Gaskraftwerke. Umweltschädliche Solarzellen und mittelalterliche Windmühlen tragen nicht zur Netzstabilität bei. Sie erzeugen Strom gemäß den Launen des Wetters, der Tages- und Jahreszeit.[35] Solcher Strom ist in einem bedarfsgesteuertem Netz wertlos. Trotzdem wird von ökobegeisterten Journalisten versucht der Bevölkerung weiszumachen, dass ein Umstieg von grund- und regellastfähiger Stromproduktion auf Zufallseinspeisung möglich sei. Auch das Wort Energieeffizienz wird umgedeutet: Unter Energieeffizienz verstehen technikferne Politiker und ökoreligiöse Journalisten an erster Stelle Schikanen für die Verbraucher wie das Glühbirnenverbot, Staubsaugerdrosselung usw. Deutschland wähnt sich dabei in einer imaginären Vorreiterrolle, die in der Praxis nur aus Abschaltplänen und dem massenhaften Zubau von Kleinanlagen mit Zufallsleistung besteht, gepaart mit Sündensteuern auf Energie, die ein kostbares Gut sein soll.

Fakt ist, dass die Uranvorräte der Erde nach menschlichen Maßstäben unerschöpflich sind, wenn die Wiederaufarbeitung und Brütertechnik genutzt wird. Die Energiefreisetzung bei der vollständigen Spaltung von 1 kg Uran ist 2,5 Millionen mal größer als bei der Verbrennung von 1 kg Steinkohle. Für die Wasserstofffusion sieht die Gewichtsbilanz mit 22,7 Millionen noch besser aus. Brut-, Spalt- und Fusionsstoffe finden sich auch auf dem Meeresgrund, oder auf anderen Himmelskörpern.[9]

- „Die Brennstoffvorräte sind unerschöpflich. Ein Bild, gebraucht von einem Schweizer Wissenschaftler, möge das deutlich machen: Wenn der Rhein Hochwasser führt, jagen an der Stadt Basel in jeder Sekunde 6000 m³ Wasser vorbei. Diese Wassermenge enthält 1 t schweres Wasser, aus dem der Ausgangsstoff für Deuterium gewonnen werden kann. Ein anderer Vergleich: Allem schweren Wasserstoff, der auf der Erde vorkommt, entspricht ein Energieäquivalent von solchen Mengen Erdöl, daß man, um sie unterzubringen zu können, einen Tank vom Durchmesser unserer Erde bauen müsste. 1,5 Trillionen t Wasser in allen Weltmeeren sind ein Energiereservoir für viele hundert Billionen Jahre.

- Energie aus Wasser – das ist die entgültige Befreiung der Menschheit von allen Energiesorgen. Noch liegt der Zeitpunkt fern, zu dem wir souverän über diese Möglichkeiten verfügen. Aber ob es sich um einige Jahre oder Jahrzehnte handelt – die Vorräte an spaltbaren Materialien reichen um ein Vielfaches länger, als zur Überbrückung dieser Zeitspanne nötig wäre.“[9]

Kernkraftwerk

![]() Hauptartikel: Kernkraftwerk

Hauptartikel: Kernkraftwerk

Heutige Kernkraftwerke sind fast ausnahmslos Leichtwasserreaktoren mit thermischem Neutronenspektrum. Diese profitierten teilweise von der militärischen Entwicklung auf diesem Gebiet, vor allem der Druckwasserreaktor als Antrieb von U-Booten. Der Siedewasserreaktor ist eine eigenständige Entwicklung und ein evolutionärer Versuch, den Aufbau eines thermischen Kraftwerkes in das Atomzeitalter zu übertragen. Moderne Kernkraftwerke sind sicher beherrschbar, zuverlässig im Betrieb und wirtschaftlich im Unterhalt. Hauptproblem sind heute die hohen Errichtungskosten, die durch staatliche Schikane beliebig in die Höhe getrieben werden können.

An der grundsätzlichen Ökonomie von Kernkraftwerken ändert sich nichts, egal ob es sich um Kernspaltungs- oder Kernverschmelzungskraftwerke handelt. Die Vorlaufkosten sind gigantisch, die Betriebskosten vernachlässigbar. Damit ähneln Kernkraftwerke großen Talsperren mit Wasserkraftwerk, die eine vergleichbare Kostenstruktur aufweisen. Beide profitieren stark von Größendegressionseffekten, auch Skaleneffekte genannt: Eine große Fabrik produziert billiger als 1000 kleine Anlagen. Aus diesem Grund werden sich Kernkraftwerke in zwei Trends entwickeln: Großkraftwerke werden stetig höhere elektrische Leistungen bereitstellen können. Der aktuelle Spitzenreiter hier ist der Framatome EPR mit über 1650 MWe. Auf der anderen Seite werden kleine modulare Reaktoren mit unter 300 MWe existieren, die kostengünstig in einer Fabrik als Massenware fabriziert werden. Diese Kleinanlagen können zu einem größeren Komplex zusammengeschaltet werden; die Modularität erhöht die gesamte Anlagenverfügbarkeit. Die nukleare Kleintechnik bietet vor allem einen Weg für Entwicklungsländer, um eine Nuklearindustrie zu einem Bruchteil der Kosten und Risiken aufzubauen, die bei Großkraftwerken anfallen würden. Diese Mini-Reaktoren können sowohl Strom als auch Heizwärme für nahe Kommunen liefern, Meerwasser entsalzen oder als Leistungsreaktoren in Schiffe verbaut werden, was die Produktionszahlen weiter steigert. Durch den kleinen, kompakten Aufbau sind passive Kühlsysteme möglich, sie sind für Jahrzehnte mit Brennstoff ausgestattet und während ihres Betriebes wartungsfrei. Die Betriebsweise entspricht der einer wartungsfreien Batterie und die Betreibergesellschaft muss dank Vollautomatisierung kein Fachpersonal bereitstellen.

Wenn Energieversorger neue Kraftwerke projektieren, sind die wichtigsten Kriterien Investitionskosten, niedrige Betriebskosten, Verfügbarkeit, Regelbarkeit, minimale Reibereien mit der Regierung und NGOs und geringe Risiken aller Art. Anders formuliert, wenn Kernkraftwerke keine ökonomischen Vorteile besitzen, werden Versorger auch noch in 50 Jahren Gas- und Kohlekraftwerke bevorzugen. Wahnvorstellungen über Verbrennungsprodukte oder das baldige Ende fossiler Reserven werden langfristig nicht helfen. Die meisten neuen Kraftwerksentwicklungen der Generation IV konzentrieren sich auf fiktive Probleme wohlstandsverwahrloster westlicher Gesellschaften wie Proliferation, Vermeidung von Atommüll und hypothetischer Risiken.

Eine zukunftsträchtige Entwicklung bei Großanlagen werden Brutreaktoren mit flüssigen Reaktorkernen aus einer Salzschmelze oder einem Eutektikum sein, oder zumindest eine Flüssigmetall- oder Flüssigsalzkühlung eines festen Reaktorkerns. Hauptschwierigkeit bei der weiteren Erhöhung der Blockleistung von Leichtwasserreaktoren sind (neben Turbosätzen) die Primärkreisläufe, wo das Wasser mit etwa 160 bar beaufschlagt wird. Da der Siedepunkt von Metallen und Salzen erheblich über dem von Wasser liegt, kann ein solcher Flüssigmetall- oder Flüssigsalzkühlkreis drucklos betrieben werden, dh er hat lediglich den dynamischen Druck der Förderpumpen. Zukünftige Kernkraftwerke werden Blockleistungen von 2000 MWe erreichen, was die obere Grenze von Leichtwasserreaktoren darstellen dürfte.

Kernkraftwerke werden regelmäßig gewartet, und Verschleißteile ausgetauscht. Dies ermöglicht bestehende Anlagen regelmäßig kostengünstig leistungszusteigern, sofern der Staat keine Hürden in den Weg legt. In den USA wurde durch Tuning der bestehenden Anlagen von 1970 bis 2018 etwa 7.923 MWe zusätzliche Erzeugungskapazität geschaffen,[36] was etwa 8 mittleren Kernkraftwerken entspricht. Da es erheblich günstiger ist, die Leistung von bestehenden Anlagen zu steigern als ein neues Kernkraftwerk zu bauen, sind die Errichtungskosten dieses fiktiven neuen Kernkraftwerkes konkurrenzlos billig. Der Preis pro installiertes Megawatt beträgt nur 15 – 50 % eines tatsächlichen Neubaus.[37]

Durch die regelmäßige Pflege und gründliche Wartung ist die Lebensdauer von Kernkraftwerken sehr hoch: Ältere Anlagen sind auf 40 Jahre konzipiert, werden aber aufgrund ihres geringen Verschleißes häufig mit einer 60-jährigen Betriebslizenz versehen.[38] Heutige Neubauten sind auf eine Kataloglebensdauer von 60 Jahren konzipiert, werden also etwa 80 Jahre in Betrieb sein, und damit ein Gegenpunkt zur kurzlebigen Wegwerfgesellschaft sein. Auch hier entspricht die Ökonomie der einer Talsperre mit Wasserkraftwerk: Talsperren haben eine konzipierte Lebensdauer von 100 Jahren, können aber dank regelmäßiger Wartung und Pflege erheblich länger am Netz sein. Anlagen wie der 1935 errichtete Hoover Dam werden so vom Kraftwerk zum Landschaftsmerkmal, zur Touristenattraktion und zur Ikone der Region.

Vulkankraftwerk

Unterhalb der Erdkruste befindet sich flüssiges Gestein durch den Stau der Akkretionswärme und der radioaktiven Zerfallswärme, analog zu einer Kernschmelze. Geoneutrino-Detektoren können den Zerfall von 238U und 232Th messen, und erlauben damit eine Schätzung ihres Beitrages zur Erdwärme. Der Zerfall von 235U und 40K ist damit nicht detektierbar, der 40K-Anteil wird aber auf 4 TW geschätzt. Durch diese Messungen wissen wir, dass etwa die Hälfte der Erdwärme durch Radioaktivität erzeugt wird.[39] Geothermie ist deshalb auch eine Art, Kernenergie zu nutzen. Das Verhältnis von Geothermie zur Radionuklidbatterie ist dasselbe, wie von einem Naturreaktor zum Kernkraftwerk.

Bohrt man an einem durchschnittlichen Ort der Erde in die Tiefe, hat man einen geothermischen Gradienten von 2,5–3K/100m.[40] Wie ersichtlich, müsste man mehrere tausend Meter tief in die Erde bohren, um genügend Wärme für einen Kreisprozess zu erhalten. An manchen Gegenden der Erde ist das Magma durch Tektonik aber nahe unter der Erdoberfläche versammelt. Dies kann man sich zu Nutze machen, indem Löcher in den Grund gebohrt werden, durch die Wasser geleitet, und heißer Dampf bezogen wird.[40] Der Dampf lässt sich dann in Turbinen zur großtechnischen, dh wirtschaftlichen Stromerzeugung nutzen. Durch diese Randbedingungen können Vulkankraftwerke nur in der Nähe eines Vulkans errichtet werden. Die alternative Bezeichnung Magma-Kraftwerk macht diesen Sachverhalt ebenfalls deutlich. An den meisten Orten der Welt gibt es aber nur die Option, bis zur nötigen Tiefe zu bohren, um die benötigten Temperaturen zu erreichen.

- „Um an diese Wärmequelle heranzukommen, müsste man Schächte bohren, die bisher, mit den derzeitigen Mitteln, nicht erreichbar sind. Abgesehen von "oberflächlichen" Schwankungen, nimmt die Temperatur in der Tiefe im allgemeinen je 33 m um 1°C zu. Man kann sich also sehr leicht ausrechnen, in welchen Tiefen die Temperaturen über dem Siedepunkt des Wassers liegen. Auf der Sohle eines Schachtes von 10 km Tiefe würden bereits 300°C herrschen, bei 20 km also 600°! Bisher haben die tiefsten Bohrungen – bei der Erdölgewinnung – 6 km Tiefe erreicht. Wie die für Erdkraftwerke erforderlichen Tiefen erreicht werden können, ist noch nicht geklärt; wenn es aber eines Tages soweit sein wird, daß Schächte bis 10 oder 15 km tief gebohrt und auf der Sohle dieser Schächte große unterirdische Becken herausgesprengt werden können, braucht man "nur" noch Wasser in diese Wasserreservoire laufen zu lassen, um Dampfkessel zu erhalten, wie sie auf der Erdoberfläche niemals gebaut werden können.“[9]

Ob in Zukunft die Möglichkeit verwendet wird, die natürliche Radioaktivität in Erdkraftwerken zu verstromen, hängt von den Kosten der Bohrung und der erzielbaren Leistung ab. Für das Vulkankraftwerk Krafla werden in weiteren Ausbaustufen Erzeugungskosten von 1,9 bis 2,2 $-ct/kWh angeführt. Die Produktionskosten des Kraftwerkes liegen bei lediglich 0,7 $-ct/kWh, der Rest sind Kapitalkosten.[41] Die Bohrungen gehen nur 1–2 km tief, erreichen aber eine Dampftemperatur von knapp 300°C. Der Kraftwerkskomplex mit seinen Rohren und Bohrfeldern erstreckt sich über 2–3 Kilometern.

Ginge es nur darum warmes Wasser aus der Erde zu beziehen, könnte man auch genauso hochradioaktive Abfälle in Wassertanks stellen, um sie als Wärmequelle zu benutzen. Der Gedanke an eine derartige Nutzung wurde in den 70er Jahren im Kernforschungszentrum Karlsruhe erwogen. Er wurde jedoch aufgegeben, da eine derartige Energiequelle aufgrund der vorherrschenden ökoreligiösen Schikanen in Deutschland nicht wirtschaftlich konkurrieren kann.

Radionuklidbatterie

Eine Radionuklidbatterie wandelt die thermische Energie des spontanen Kernzerfalls eines Radionuklids in elektrische Energie um. Durch ihre Funktionsweise sind Radionuklidbatterien klein und kompakt, erreichen aber nur vergleichsweise geringe Leistungen. Sie sind praktisch wartungsfrei und können über Jahre bis Jahrzehnte hinweg elektrische Energie liefern. Charakteristisch ist der zeitlich exponentielle Leistungsabfall durch die Halbwertszeit des eingesetzten Radionuklids. Bei relativ großen Halbwertszeiten spielt dies aber keine Rolle.

Einsatzgebiete sind zB Herzschrittmacher, Atomautos, Raumsonden und die Stromversorgung von unzugänglichen Gebieten der Erde und im All. Besonders bei Raumfahrtmissionen, die sich in den äußeren Planeten abspielen und auch für einige militärische, niedrig fliegende Aufklärungssatelliten haben sich Radionuklidbatterien durchgesetzt. Radionuklidbatterien werden dabei so ausgelegt, dass auch bei Zerstörung des Satelliten durch Explosion oder Wiedereintritt in die Atmosphäre und Verglühen kein radioaktives Material austritt. Ein Beispiel dafür ist die Radionuklidbatterie SNAP-27, die als Stromerzeugungsaggregat auf dem Mond eingesetzt wurde.

Bei Raumfahrtmissionen wird in der Regel Plutonium-238 eingesetzt, da es bezüglich Kosten, Energiedichte und Halbwertszeit Vorteile bietet. Plutonium-238 muss dafür in Kernreaktoren erbrütet werden. Für leistungsstarke Atombatterien, die unzugängliche Gebiete der Erde mit Strom versorgen sollen, werden radioaktive Substanzen verwendet, die aus abgebrannten Kernbrennstäben in der Wiederaufarbeitung extrahiert werden können, wie Strontium-90. Da der Wirkungsgrad der wartungsfreien thermoelektrischen Wandler sehr gering ist, werden in Zukunft Sterlingmotoren oder Alkalimetall-thermisch-elektrische Wandler (AMTEC) die Konversion von thermischer in elektrischer Energie übernehmen.

Verkehr

- „Die Veranstaltung nannte sich „Festival der Utopien“. Zwei Tage hatten die in verschiedene Gruppen aufgeteilten Studenten Zeit, sich Gedanken über die Mobilitätssysteme der Zukunft zu machen. Am Ende wurden die Ergebnisse einer Reihe geladener, als „Strippenzieher“ titulierter Gäste präsentiert. Nicht primär Fachleute waren angesprochen, sondern eher Multiplikatoren aus Wirtschaft, Wissenschaft und Verwaltung. Dies mag erklären, warum die Vorstellungen der Studenten mit einem gewissen Wohlwollen betrachtet wurden. Man fand scheinbar amüsant, was gezeigt wurde. Ich dagegen war erschrocken und verärgert, was ich auch deutlich zum Ausdruck brachte.

- „Mobilität“ empfanden die durchweg gesellschaftswissenschaftlich orientierten Nachwuchsakademiker als etwas Bedrohliches, das auf eine im diffusen bleibende Weise die Menschen unglücklich macht und die Erde zerstört. Die zu ziehende Konsequenz erschien daher zwingend: Mobilität gehört abgeschafft. Da das aber nicht geht – und so viel Realitätssinn war durchaus noch vorhanden – verfiel man auf eine naheliegende Alternative: Das Beamen. Mobilitätsbedarfe würden in Zukunft also ganz einfach durch Maschinen abgewickelt, durch die Güter und Personen zeitverlustfrei und ohne sich physisch bewegen zu müssen, von einem Ort zum anderen teleportieren. Den Weg zu diesen Maschinen sollte man per Pferd und Luftschiff zurücklegen können – letzteres mit Pferdemist angetrieben.

- Zu kritisieren sind solche Phantasien nicht nur wegen ihrer offensichtlich ökologistischen Motivation. Viel erschreckender war in diesem konkreten Fall die Vehemenz, mit der sich gebildete junge Erwachsene auf Vorstellungen jenseits des physikalisch möglichen und denkbaren versteiften. Weder Energie-, noch Impuls- oder Massenerhaltung zählten, obwohl diese doch einen nicht veränderbaren Rahmen für das Verhältnis von Aufwand und Nutzen technischer Systeme vorgeben. Man darf sich darüber nicht wundern in Zeiten, in denen diese Art zu denken von der Politik vorgelebt wird.“

- – Dr. Peter Heller, Astrophysiker[42]

Deindustrialisierung sowie ein allgemeines Absenken des Lebensstandards ist das Ziel einer wildgewordenen Politikerkaste und ihrer grünen Multiplikatoren. Betrachtet man die Mobilität mittels Kraftmaschinen aus wissenschaftlicher Perspektive, landet man beim Gabrielli-Kármán-Diagramm. Der Physiker Theodore von Kármán und der Luftfahrtingenieur Giuseppe Gabrielli stellten 1950 anhand einer Datenanalyse fest, dass wenn man die spezifische Traktionskraft (definiert als Antriebsleistung geteilt durch Masse mal Höchstgeschwindigkeit) in einem doppelt logarithmischen Diagramm über der Höchstgeschwindigkeit aufträgt, alle Mobilitätssysteme die sich am Markt durchgesetzt haben entlang einer Linie verlaufen. Diese Gabrielli-Kármán-Linie hat sich 2004 bestätigt, als die Daten aktualisiert wurden.[43]